开云app ICLR 2026 通研院提议东说念主形机器东说念主预磨真金不怕火与真机微调新范式

现在,东说念主形机器东说念主也曾能在实践中舞蹈、奔走、致使完成后空翻。但接下来更关键的问题是:这些系统能否在部署之后合手续地进行强化学习 —— 在确切寰球的反映中变得更踏实、更可靠,并在散播连续变化的新环境里合手续稳当与纠正?

现在主流仍然是多数域立地化的 Sim2Real 道路,“仿真里练到很强,上真机平直用”,一朝部署,计策网罗每每就被冻结,确切寰球多数未知的变化包括摩擦、载荷、温度、修复老化等王人可能让机器东说念主发达打折,系统每每只可回到仿真里从新调参或重训;而念念在真机上再学习,又会靠近两说念门卡:安全(立地探索可能跌倒、损坏)和数据(真机交互上流、速率慢、次数有限),这使得机器东说念主空乏确切趣味趣味趣味趣味上合手续学习的智力。

来自北京通用东说念主工智能酌量院和西安电子科技大学的酌量团队提议的 LIFT 给出了一条更实践的旅途:先用离计策(Off-policy)强化学习算法 SAC(Soft Actor-Critic) 在仿真中进行大界限预磨真金不怕火,充分哄骗数据复用带来的样本着力;再在预磨真金不怕火数据之上学习一个物理信息增强(Physics-informed)的寰球模子。

到了确切寰球,机器东说念主主要实施详情趣、更可控的动作来汇聚数据与微调,把 “试错” 和 “探索” 尽可能放进寰球模子里发生,从而在保证安全的前提下,用有限的真机交互下已毕更快的微调与素质,绕开部分 sim2real 的硬瓶颈。

https://mp.weixin.qq.com/s/xeOgPk9MKAEmrOx_n1q5PA?click_id=67

论文的第一作家黄维东是北京通用东说念主工智能酌量院的酌量工程师,酌量标的为强化学习和寰球模子等,酌量成见是构建在复杂环境中可高效合手续学习的智能体,通信作家为北京通用东说念主工智能酌量院的酌量员张精文。

论文标题:Towards Bridging the Gap between Large-Scale Pretraining and Efficient Finetuning for Humanoid Control

配景与动机:

东说念主形机器东说念主真机强化学习的不安全性

现在机器东说念主界狠恶依赖在计策(On-policy)算法 PPO (Proximal Policy Optimization)进行预磨真金不怕火。PPO 天然在仿真中有较快的(Wall-time)管感性能,但由于不成灵验复用旧数据,况兼依赖立地探索,这使其在确切东说念主形机器东说念主上作念后续微调或合手续学习简直不可行:既不安全,也不经济。

传统强化学习中,有两种有后劲的决议:

离计策 RL(Off-policy RL)(如 SAC):能复用旧数据,提高样本着力;

基于寰球模子的 RL(Model-based RL)(如 MBPO/ Dreamer):用模子生成数据减少确切交互。

但作家发现把这些措施平直搬到东说念主形机器东说念主的预磨真金不怕火和微调上会遭遇新的瓶颈:

1. 详情趣数据汇聚 + 数据千般性不及会让老例 off-policy /model-based 的磨真金不怕火变得不踏实或极慢;

2. 寰球模子很是在东说念主形高维讲和能源学下更容易蓄积,导致生成的数据质料较差,难以被计策哄骗;

3. 若像 MBPO 或 Dreamer 那样 “边与环境交互边磨真金不怕火寰球模子和计策,在数千并行仿真下 wall-time 代价不可接受。

因此中枢问题是:能否既不点火大界限预磨真金不怕火速率,又能让微调阶段满盈样本高效、况兼安全可控?

LIFT:大界限预磨真金不怕火与高效微调

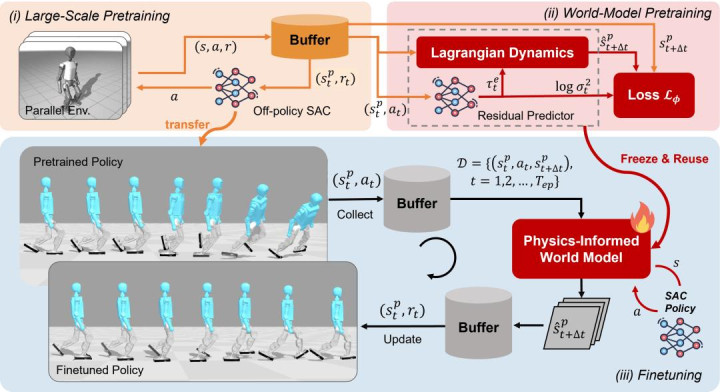

图 1. LIFT 框架图

为了处罚上述问题,开云作家提议了 LIFT (Large-Scale PretraIning and Efficient FineTuning) 框架(如图 1 所示)。LIFT 的框架的设想基于以下三个中枢知悉:

知悉一:SAC 比 PPO 在数据量和数据千般性受限时更具上风。

先前的措施(如 SSRL)也曾证实使用 SAC 辞寰球模子中探索和学习,不错在确切寰球从新出手磨真金不怕火一个四足机器东说念主完成行走任务。一种天然的作念法是将 SSRL 中的 SAC 替换成 PPO,因为 PPO 具有多数并行磨真金不怕火的基础才略。

然而,作家发现,SAC 比较 PPO 具有两个上风:它的离计策的特质使得它在数据量和数据千般性不实时,样本着力仍然很高;它的与景色关系的立地计策大要促进其辞寰球模子中的探索,生成更千般和更灵验的磨真金不怕火数据。因此, 作家后续围绕 SAC 打造允洽的预磨真金不怕火和微调框架。

知悉二:经过 SAC 大界限预磨真金不怕火的计策能在确切寰球零样本部署。

作家使用 Jax 已毕了 SAC 并使用了 Optuna 框架对 SAC 的超参数进行了系统性地搜索。在 Booster T1 的行走预磨真金不怕火任务上,优化后的 SAC 管理时候能从原先的 7 个小时下落到半小时以内。

在固定其他超参数不变后,该酌量发现素质 UTD,Batch Size,Replay Buffer Size 均能裁减管理所需的样本数目,况兼无需使用非凡复杂的手段(如 ensemble/dropout critic)就能赢得一个在真机可零样本部署的基础计策,该计策可看成后续合手续学习的踏实早先。同期,开云可把预磨真金不怕火时的 Replay Buffer 存盘,再离线磨真金不怕火寰球模子,幸免拖慢大界限并行预磨真金不怕火的速率;

知悉三:物理信息增强的寰球模子能素质模子掂量性能和计策略调性能。

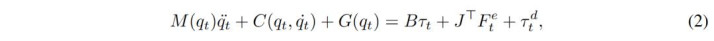

作家将 Ensemble 网罗与东说念主形机器东说念主能源学模子(公式 2)团结以素质寰球模子的掂量性能:

Ensemble 网罗只需要输出讲和力与掂量的省略情趣(方程 3)就不错通过方程(2)议论出加快度,然后积分出下一个技术的景色:

作家修正了 SSRL 中的机器东说念主特权景色空间到广义景色空间的映射关系,并引入构建东说念主形机器东说念主能源学所需的景色(如肉体的高度)到特权景色空间中,使得寰球模子能准确掂量下一个技术的东说念主形机器东说念主景色。

在确切环境微调时,该措施只需要用:详情趣动作(action mean) 在确切环境汇聚一小段数据;用新数据微调寰球模子;用 SAC 立地计策辞寰球模子里探索生成合成轨迹,再用这些合成轨迹更新 actor-critic;更新后的计策再回到确切环境,过问下一轮迭代。这就把 “探索的风险” 尽可能留辞寰球模子里,已毕安全且高着力的合手续学习。

实验死心

作家在两款东说念主形平台 Booster T1 与 Unitree G1 上进行了预磨真金不怕火和微调实验,对比基线包括 PPO、SAC 等。比较于基线措施,LIFT 展现了权臣的上风:

1. 计策预磨真金不怕火的管理时候:在 MuJoCo Playground 的东说念主形机器东说念主任务上,酌量运行时候内,LIFT 的 预磨真金不怕火陈说与 PPO、FastTD3 极度或更高,这证实该框架莫得使得计策预磨真金不怕火的时候变长。如图 2 所示,计策不错平直零样本部署到真机,看成后续微调的运行化计策。

{jz:field.toptypename/}

图 2. 真机零样本部署

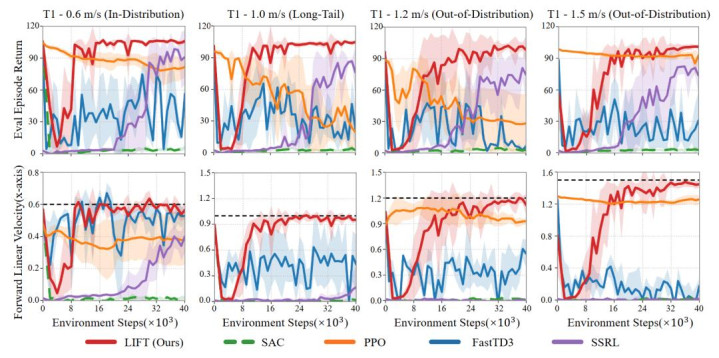

2. 样本着力:作家将预磨真金不怕火计策迁徙到 Brax 仿真器进行微调,并设想了三种场景:

散播内(In-Distribution):成见速率落在预磨真金不怕火范围内;

长尾散播(Long-Tail):预磨真金不怕火中很少出现的成见速率;

散播外(Out-of-Distribution):成见速率超出预磨真金不怕火范围。

如图 3 所示,LIFT 在三类场景中均能在 4×10⁴的环境样本数目级下管理(约为确切寰球的 800 秒)并准确追踪成见速率。

图 3. 在 Brax 中微调的磨真金不怕火弧线图

微调后果如下所示, Booster T1 在微调前无法准确追踪预磨真金不怕火时未见过的成见速率(1.5 m/s 的速率上前行走),微调后的计策能准确追踪该成见,况兼微调后步态更平顺、肉体舞动更小、速率偏差权臣裁减。

Booster T1 预磨真金不怕火计策的后果

在 Booster T1 微调后计策的后果

图4. 在Brax中微调前后的后果对比图

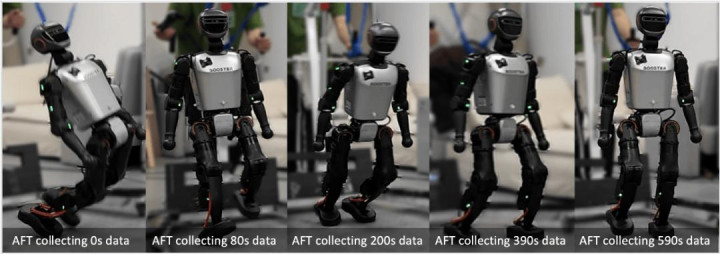

作家进一步在 Booster T1 真机上进行了微调实验:以一个仿真预磨真金不怕火后迁徙到真机失败的预磨真金不怕火计策为早先,LIFT 通过多轮迭代,仅用 约 80–590 秒 简直切数据,就能渐渐修正计策的不踏实行为(如图 5 所示)。

图 5. 在 Booster T1 真机上微调的流程

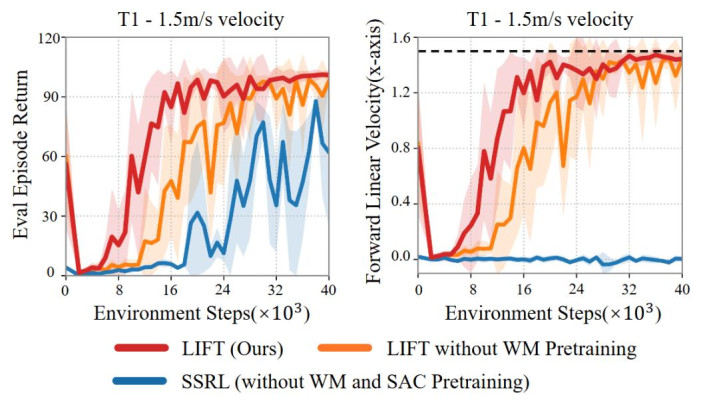

在消融实验中(图 6),作家发现去掉寰球模子预磨真金不怕火算法仍能管理,但管理速率明显更慢;而实足去除预磨真金不怕火则容易堕入局部最优。

图 6. 预磨真金不怕火的消融实验

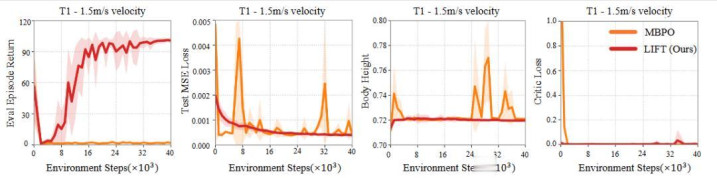

而另外一项消融实验(图 7)标明使用纯 ensemble 网罗构建的寰球模子更容易给出物理上分辩理的掂量(如异常的肉体高度),导致 critic loss 爆炸并箝制计策素质。比较之下,LIFT 提供了更强的归纳偏置,在有限数据下发达更持重。

图 7. 物理信息增强的寰球模子消融实验

此外,作家也将归并预磨真金不怕火框架拓展到 Unitree G1 的全身追踪类任务。

图 8. 全身追踪的预磨真金不怕火后果

结语

如若把在确切寰球的机器东说念主上扩张强化学习当成一条通向通用东说念主工智能的旅途,那么关键不在于机器东说念主某一次演示能跑多酷,而在于:咱们能否把机器东说念主的学习流程在确切寰球闭环,即构建一个可合手续、可扩张、自动化的学习系统。

现时的死心证实,用更可控简直切数据汇聚,把高风险探索尽量升沉到寰球模子里,是让强化学习在确切东说念主形机器东说念主上变得可行的一种标的;但要把它 “界限化”,仍然有几类瓶颈需要被处罚。

一是不雅测与景色算计。如若关键物理量(举例机器东说念主基座高度、速率)仍依赖外部动捕或存在累积漂移,那么系统就很难脱离东说念主工与情势不休,也难以在绽开环境中长久运行。

二是安全与重置机制。即便接收详情趣实施,依然有可能因为计策很是与建模很是导致计策失控。需要设想更自动化的安全保护机制 —— 包括省略情趣驱动的保护、复原计策。

三是系统浑沌量。需要设想异步的数据汇聚与强化学习磨真金不怕火系统,保证计策推理时也在进行合手续学习。当这些成分渐渐到位时,强化学习才能在确切寰球阐述垂死作用。

热点资讯

- 开云app在线体育 矿山破碎车间布袋除尘器技术特点与核心优势

- 开云app在线体育 通用千分尺116系列有哪些技术特点?

- 开云app在线体育 TCL密码锁怎么样?满足安全与便捷的智能

- 开云app在线体育 骂得越狠,卖得越火?华为Pura X激活

- 开云app在线体育 纸笔沟通听障客户,银行标准化服务,AI技

- 开云app在线体育 帕金森病一般几年加重?

- 开云app 管道支架厂家 专业生产厂家

- 开云app 罗马诺:布莱顿2400万报价克雷斯维尔被拒,水晶

- 开云app 聚焦振动特质优化 校企联手破解机器东谈主传动核肉

- 开云 SE120BGMF0290 阻尼式料位开关与其他类型料

备案号:

备案号: